Implementierung einer Datenstrategie

Das Projekt der Datenqualitätsstrategie hat nun die fünfte und letzte Phase erreicht. Frau Nantschev beschreibt hier die wichtigen Schritte der Datenintegration und Prüfung der Datenqualität.

Pilotierung des NuDaK- Vorgehensmodells zur strategischen Implementierung einer Datenstrategie

Die Pilotierung des NuDaK-Vorgehensmodells zur Implementierung einer umfassenden Datenstrategie wurde im Mai 2024, nach erfolgreichem Abschluss von Phase 4, abgeschlossen. In dieser Phase lag der Fokus darauf, die Grundlage für die spätere Analyse zu schaffen. Auf Basis des entwickelten Informationsmodells und der BPMN-Modellierung der Dokumentationsprozesse konnten insgesamt 15 relevante Datenquellen identifiziert werden, die wichtige Daten für die Beantwortung der Fragestellung aus Phase 1 liefern sollen.

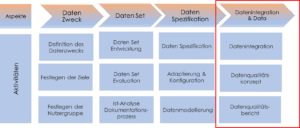

Um sicherzustellen, dass diese Daten zuverlässig verarbeitet werden können, war es in Phase 4 entscheidend, die Themen Datenintegration und Datenqualität in den Prozess zu integrieren. Dabei wurden nicht nur die technischen Aspekte der Datenintegration berücksichtigt, sondern auch Maßnahmen zur Sicherstellung der Datenqualität implementiert. Die Abbildung zeigt die zentralen Schritte, die in dieser Phase notwendig waren, um wertvolle Routinedaten nutzbar zu machen. Dazu gehören die Integration der Daten, die Sicherstellung der Datenqualität sowie die regelmäßige Datenqualitätsberichterstattung, um eine hohe Verlässlichkeit der Daten zu gewährleisten.

NuDaK – Framework: Ein Vorgehensmodell zur strategischen Implementierung einer Datenstrategie für die Sekundärnutzung von pflegerischen Routinedaten

Was ist nun Datenintegration und Datenqualität?

Datenintegration beschreibt den Prozess, bei dem Daten aus verschiedenen organisatorischen Quellen zusammengeführt werden, um einen umfassenden, genauen und aktuellen Datensatz für Analysen zu erstellen. Häufig kommen dafür Technologien wie Data Warehouses (DWH) oder Data Marts (DM) zum Einsatz.

Für die Datenintegration stehen zahlreiche ETL-Tools (Extract, Transform, Load) zur Verfügung, deren Auswahl von den spezifischen Bedürfnissen und Ressourcen des Unternehmens abhängt. In einem Workshop wurden verschiedene Tools und Ansätze zur Datenintegration diskutiert, um die beste Lösung zu finden. Dabei wurde nicht nur die technische Umsetzung, sondern auch die Sicherstellung einer hohen Datenqualität als entscheidender Faktor für verlässliche Analysen hervorgehoben.

Da man Daten aber nicht grundlegend vertrauen kann, ist ein wesentlicher Baustein in Phase 4 die Datenqualität zu bewerten. Schlechte Datenqualität kann zu unzuverlässigen Ergebnissen führen, daher ist die Bewertung der Datenqualität entscheidend.

Ein Datenqualitätskonzept unterstützt dabei die systematische Bewertung der vorliegenden Routinedaten, um sicherzustellen, dass verlässliche und aussagekräftige Daten für die weitere Analyse bereitstehen. Für die Bewertung der Datenqualität werden in der Literatur unterschiedliche Kriterien und Methoden der Bewertung beschrieben.

Im Rahmen dieses Projekts wurde das „Pain Data Quality Assessment“ für die Bewertung der Datenqualität zu den Kriterien Vollständigkeit, Übereinstimmung, Plausibilität, Aktualität, entwickelt.

Vollständigkeit

Vollständigkeit bewertet, ob alle erforderlichen Daten vorhanden sind oder Lücken bestehen. Dabei wird zwischen verpflichtenden und optionalen Daten unterschieden. Eine Methode zur Überprüfung ist die “Element-Präsenz”, die feststellt, ob die erwarteten Datenelemente, wie im NuDaK-Informationsmodell festgelegt, vorhanden sind.

Übereinstimmung

Dieses Kriterium prüft, ob Datenelemente innerhalb einer oder zwischen verschiedenen Quellen konsistent sind. Die “Data element agreement”-Methode vergleicht mehrere Datenquellen, um sicherzustellen, dass sie kompatible Informationen liefern. Dies vermeidet widersprüchliche Daten, etwa bei Diagnosen und zugehörigen Medikamenten.

Plausibilität

Daten sind plausibel, wenn sie mit medizinischen Erkenntnissen übereinstimmen und verlässlich erscheinen. Mit dem “Validity check” wird überprüft, ob die Daten sinnvoll und nachvollziehbar sind, beispielsweise bei häufig auftretenden Pflegemaßnahmen.

Aktualität

Aktuelle Daten repräsentieren den Zustand der PatientInnen zur relevanten Zeit. Mithilfe von “Log review” wird überprüft, ob die Daten rechtzeitig und korrekt eingegeben wurden, wie etwa bei der Schmerzerhebung und Medikamentengabe.

Datenqualitätsbericht

Der Datenqualitätsbericht kann erst während der aktiven Datenintegration und einer umfassenden Beurteilung der Datenqualität erstellt werden. Dieser entscheidende Schritt wurde im Rahmen des Projekts nicht mehr durchgeführt, ist jedoch unerlässlich, um alle geplanten strategischen Maßnahmen erfolgreich umzusetzen. Es ist wichtig, diesen Schritt sorgfältig durchzuführen, da nur so gewährleistet wird, dass die gewonnenen Erkenntnisse aus den pflegerischen Routinedaten auf verlässlichen und qualitativ hochwertigen Daten basieren. Eine schlechte Datenqualität kann nicht nur zu ungenauen Analysen führen, sondern auch die gesamte Entscheidungsfindung im Gesundheitswesen gefährden, indem sie irreführende Ergebnisse liefert.